Sztuczna Inteligencja w fotografii - przeszłość, teraźniejszość i przyszłość

2. Co już widzieliśmy?

Rys. WIPO Technology Trends 2019 |

Zacznijmy zatem od rozwiązań już obecnych na rynku. Skupię się tutaj jednak nie tylko na lustrzankach czy bezlusterkowcach, ale także na smartfonach (gdzie wszelkie nowinki najczęściej implementowane są najszybciej) oraz oprogramowaniu.

Lustrzanki i bezlusterkowce

Stosunkowo niedawno premierę miały dwa modele aparatów, których producenci chwalili się użyciem sztucznej inteligencji. Pierwszym z nich jest Sony A6400. Tutaj algorytmy Deep Learningowe użyte są do poprawienia śledzenia oka oraz śledzenia obiektów. Jakie mogą być korzyści z użycia AI do tego zadania? Klasycznie, do wykrywania oczu czy obiektów używane są standardowe metody wizji komputerowej. W kwestii oka, „ręcznie” wyszukuje się cechy charakterystyczne twarzy na pojedynczych klatkach, a następnie – w obszarze wysegmentowanym jako twarz - szuka się oka. Wykorzystanie modelu nauczonego na wielu przykładach jak wygląda twarz oraz oko, który sam ekstrahuje cechy oka, może zarówno przyspieszyć wykrywanie (pozbędziemy się często obecnego opóźnienia, które może wpływać na dokładność autofokusa), a także powinno poprawić ilość przypadkowych wykryć oka – czyli momentów, w których aparat zobaczy twarz i oko na chmurach czy na drzewach, które mają wystarczającą ilość cech do tego, aby błędnie zakwalifikować je jako twarz czy oko. Modele Deep Learningowe są bowiem znacznie bardziej dokładne od klasycznych, bazujących na ręcznie „wyciąganych” cechach. Dodatkowo, pozwala to na wykrywanie oczu nie tylko ludzi, ale i zwierząt. Wystarczy wytrenować modele Deep Learningowe dużą ilością pysków zwierząt z różnych gatunków tak, aby ten nauczył się cech charakterystycznych twarzy oraz oka danego rodzaju zwierzęcia. Następnie, podczas detekcji, wykrywany jest rodzaj zwierzęcia oraz jego oko. Rys. Sony |

Podobne podejście do kwestii AI w swoich aparatach ma Olympus. Niedawna premiera E-M1X wprowadziła ze sobą metody wykrywania obiektów za pomocą sztucznej inteligencji. Znowu zatem mamy do czynienia z usprawnieniem tylko i wyłącznie autofokusa – i nie ma w tym nic dziwnego, bo wydaje się, że w aparatach to właśnie autofokus może być głównym beneficjentem Deep Learningowych metod. Tutaj z kolei producent zaimplementował głębokie uczenie do wykrywania (oraz segmentacji) obiektów – samochodów oraz motocyklów, samolotów oraz pociągów. Dzięki temu, że aparat będzie wiedział, co „widzi”, ustawienie ostrości ma być sprawniejsze i dokładniejsze poprzez fakt, że ruch każdego z tych obiektów jest na swój sposób specyficzny.

W zasadzie dokładnie to samo zobaczyliśmy w aparatach pełnoklatkowych Panasonic – za pomocą sztucznej inteligencji aparat jest w stanie wykryć człowieka, ptaka oraz psa czy kota. Świadomość, co śledzi aparat, pozwala mu na lepsze przewidzenie ruchu oraz śledzenie obiektu nawet, gdy jest odwrócony.

Natomiast pierwszym rozwiązaniem, dumnie nazywanym „AI”, był Canonowski AI Servo autofocus, pochodzący z roku 2009. Tryb ten nie polegał jednak na tym, co wyżej wspomniane rozwiązania Olympusa i Sony. Canon używał sztucznej inteligencji do efektywnego zarządzania punktami, które brały udział w śledzeniu obiektu.

Możemy się domyślać, że kolejni producenci będą implementować swoje algorytmy wspierające autofokus i wykrywanie oraz śledzenie obiektów będzie jeszcze dokładniejsze. To, na czym jeszcze mogą zyskać producenci zwracając się w stronę algorytmów sztucznej inteligencji, jest stabilizacja. Nad tą kwestią pochylimy się jednak nieco dalej.

Smartfony

Tutaj mamy znacznie więcej gotowych rozwiązań czerpiących wprost ze sztucznej inteligencji. Producentem, który przoduje w implementacji najnowszych algorytmów wizji komputerowej w gotowych urządzeniach jest chiński gigant Huawei.Zacznijmy zatem od właśnie tej firmy. To ona jest bowiem najbardziej kojarzona ze słowem „AI”, gdyż duża część jej ostatnich materiałów prasowych i reklam skupia się właśnie na tym temacie. Warto zaznaczyć, że skupimy się jedynie na rozwiązaniach usprawniających aparat fotograficzny, a nie inne komponenty telefonu. Pytanie zatem, na ile mamy do czynienia z marketingową „papką”, a na ile rozwiązania te rzeczywiście mogą pomóc użytkownikom w robieniu lepszych zdjęć?

Rys. Huawei |

Kolejną funkcjonalnością chińskiego potentata jest stabilizacja obrazu wspierana przez sztuczną inteligencję (AIS) – dzięki niej producent zaimplementował tryb zdjęć nocnych, podczas których smartfon musi pozostać nieruchomy przez około 6 sekund. Jak to działa? W smartfonach producenta mamy do dyspozycji optyczną stabilizację obrazu. Za pomocą sztucznej inteligencji, smartfon analizuje na bieżąco scenę oraz ocenia ruchy smartfonu i, mając do dyspozycji stabilizację obrazu, stara się kompensować ruchy w jak najwydajniejszy sposób. W zasadzie więc sztuczna inteligencja po prostu „steruje” OIS. W trybie nocnym, smartfon dodatkowo analizuje wykonane zdjęcia i składa je w jak najlepszy sposób. Niestety, szczegółów tej technologii nie poznaliśmy - producent nie podzielił się żadną publikacją naukową na temat AIS.

Poza Huaweiem, algorytmy sztucznej inteligencji do rozpoznawania obrazów znajdziemy w smartfonach Apple, Oppo czy Google. W telefonach tych producentów zaimplementowano między innymi tryb portretu przy użyciu pojedynczego obiektywu, dzięki któremu, robiąc zdjęcie sobie czy komuś innemu możemy nanieść efekt automatycznego rozmycia tła, tak, by fotografia przypominała tę wykonaną profesjonalnym aparatem. Funkcja ta polega na automatycznym rozpoznaniu osoby na zdjęciu, dokonaniu segmentacji fotografowanego motywu od tła oraz rozmyciu tła w jak najbardziej naturalny sposób.

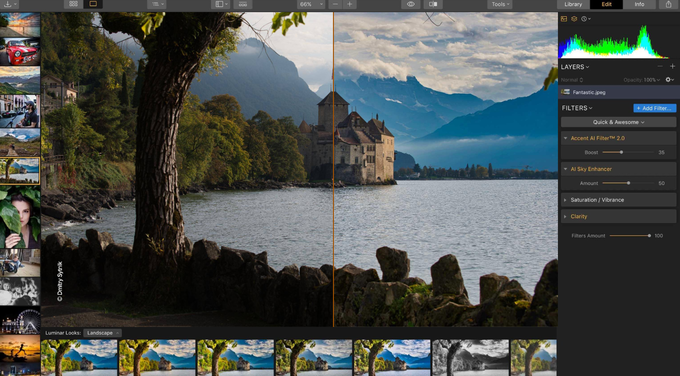

Oprogramowanie do obróbki

Równie ważnym, jak nie najważniejszym beneficjentem technologii głębokiego uczenia jest oprogramowanie do obróbki zdjęć. Oprogramowanie Luminar w wersji 3 wprowadziło suwaki o nazwie „AI”. Wystarczy, że przeciągniemy dany suwak w prawo, a oprogramowanie wykona całą robotę z obróbką za nas – jeden odpowiada za nałożenie filtra dostosowanego do rozpoznanej sceny, a drugi segmentuje niebo na zdjęciu i wzmacnia jego nasycenie oraz dodaje nieco „dramatyzmu”. Rys. Luminar |

Rys. Luminar |

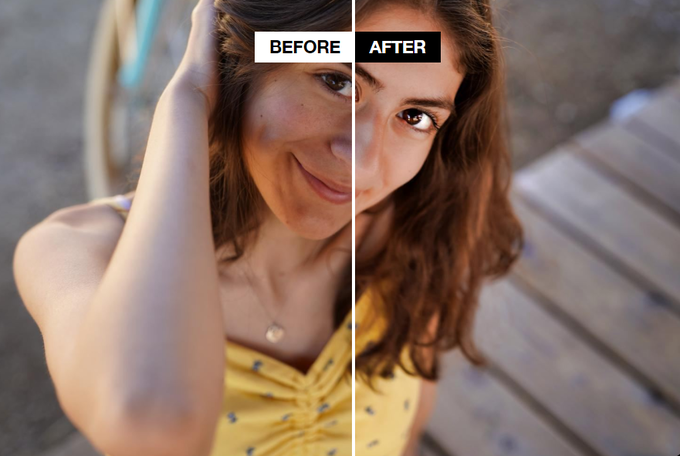

Podobnie działa oprogramowanie Photolemur 3. Software ten przychodzi jednak z jedną dodatkową opcją – automatyczną obróbką twarzy. Po wczytaniu zdjęcia, na którym znajduje się model czy modelka, program nałoży filtry wygłądzające skórę, usuwające niedoskonałości, uwydatniające oczy oraz wybielające zęby.

Rys. Photolemur |

Rys. Adobe |

Kolejnym rozwiązaniem Adobe, tym razem dostępnym w programie Photoshop, jest One Click Subject Selection. Naukowcy wykorzystali sztuczną inteligencję do dokładnej segmentacji zaznaczonego przez użytkownika obiektu. Narzędzie to pojawiło się po raz pierwszy w programie Photoshop CC na początku 2018 roku.

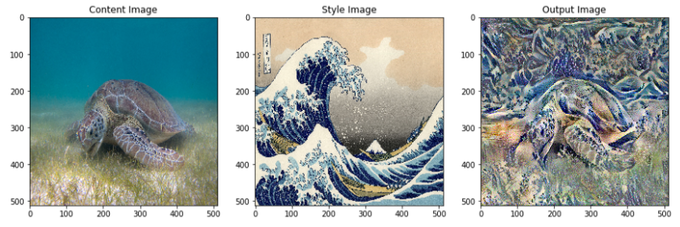

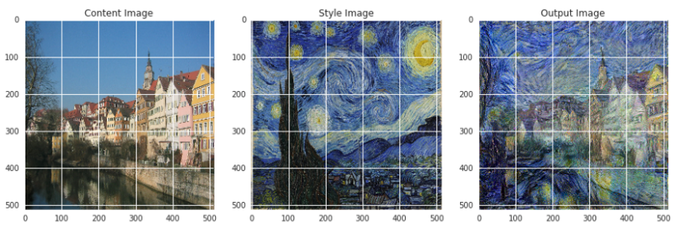

Poza profesjonalnym oprogramowaniem do obróbki zdjęć, mamy na rynku całą masę aplikacji działających na smartfonach. Swego czasu dużą popularność zdobył program Prisma, który na nasze zdjęcia automatycznie nakładał filtry zbliżające wgraną fotografię do dzieła sztuki. Podobnie działa również DeepArt. Obie te aplikację zasadę swojego działania opierają na tak zwanym transferze stylu (ang. Neural Style Transfer), który czerpie bezpośrednio z głębokiego uczenia. Jak to działa?

Jeżeli mamy do dyspozycji dwa zdjęcia, wytrenowana sieć neuronowa nałoży na wejściowe zdjęcie styl, na którym została wytrenowana. Przykłady można zobaczyć poniżej.

Rys. https://medium.com/tensorflow/neural-style-transfer-creating-art-with-deep-learning-using-tf-keras-and-eager-execution-7d541ac31398 |

Rys. https://medium.com/tensorflow/neural-style-transfer-creating-art-with-deep-learning-using-tf-keras-and-eager-execution-7d541ac31398 |

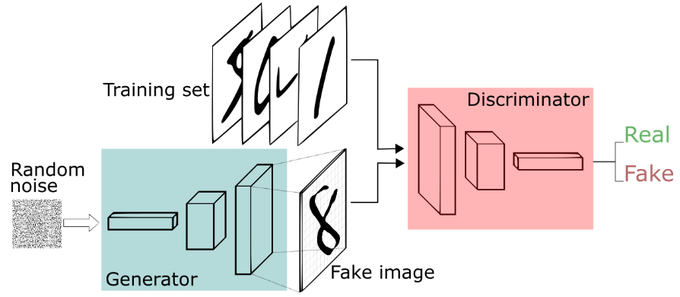

Rys. https://skymind.com/wiki/generative-adversarial-network-gan |

Fot. Archiwum własne / FaceApp |

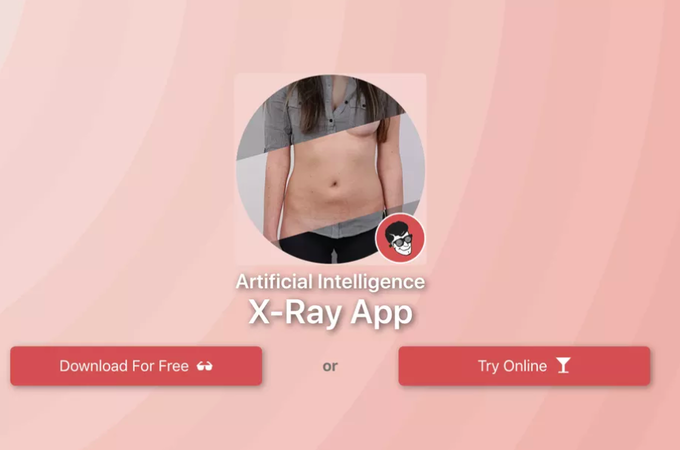

Rys. DeepNude |

Kolejnym ciekawym wykorzystaniem sztucznej inteligencji, które w zasadzie stoi w kontrze do dwóch przedstawionych wyżej aplikacji, jest narzędzie Adobe. Pozwala ono wykryć zdjęcia, na których dokonano jakiejkolwiek manipulacji – zarówno poprzez wykorzystanie narzędzi DeepFake, takich jak FaceApp czy DeepNude, jak i po prostu użycia znanego "photoshopowego" narzędzia Liquify. Jak na razie, algorytm został wytrenowany tylko na tym ostatnim i jest w stanie z 99-procentową dokładnością stwierdzić, czy zdjęcie zostało poddane manipulacji, czy nie.

Kolejnym rozwiązaniem już obecnym na rynku, używającym (w większości implementacji) omówionych wyżej GAN-ów jest tak zwane „bezstratne” powiększanie zdjęć. Najpopularniejszym narzędziem jest Topaz AI Gigapixel. Poza tym, w internecie znajdziemy jeszcze programy Bigjpg oraz LetsEnhance. My sprawdziliśmy, jakie efekty udaje się osiągnąć, powiększając zdjęcie, używając ostatniego z wymienionych programów. Powiększyliśmy widoczne poniżej zdjęcie 4-krotnie, używając Photoshopa oraz LetsEnhance.

Fot. Archiwum własne |

Efekty, w postaci 100-procentowego wycinka, prezentujemy poniżej. Kliknięcie na zdjęcie wyświetli odpowiednią fotografię w pełnej rozdzielczości.

| Adobe Photoshop 2019 | LetsEnhance |

|

|

_1877607562.jpg)

_968856305.jpg)

Optyczne.pl jest serwisem utrzymującym się dzięki wyświetlaniu reklam. Przychody z reklam pozwalają nam na pokrycie kosztów związanych z utrzymaniem serwerów, opłaceniem osób pracujących w redakcji, a także na zakup sprzętu komputerowego i wyposażenie studio, w którym prowadzimy testy.

Optyczne.pl jest serwisem utrzymującym się dzięki wyświetlaniu reklam. Przychody z reklam pozwalają nam na pokrycie kosztów związanych z utrzymaniem serwerów, opłaceniem osób pracujących w redakcji, a także na zakup sprzętu komputerowego i wyposażenie studio, w którym prowadzimy testy.